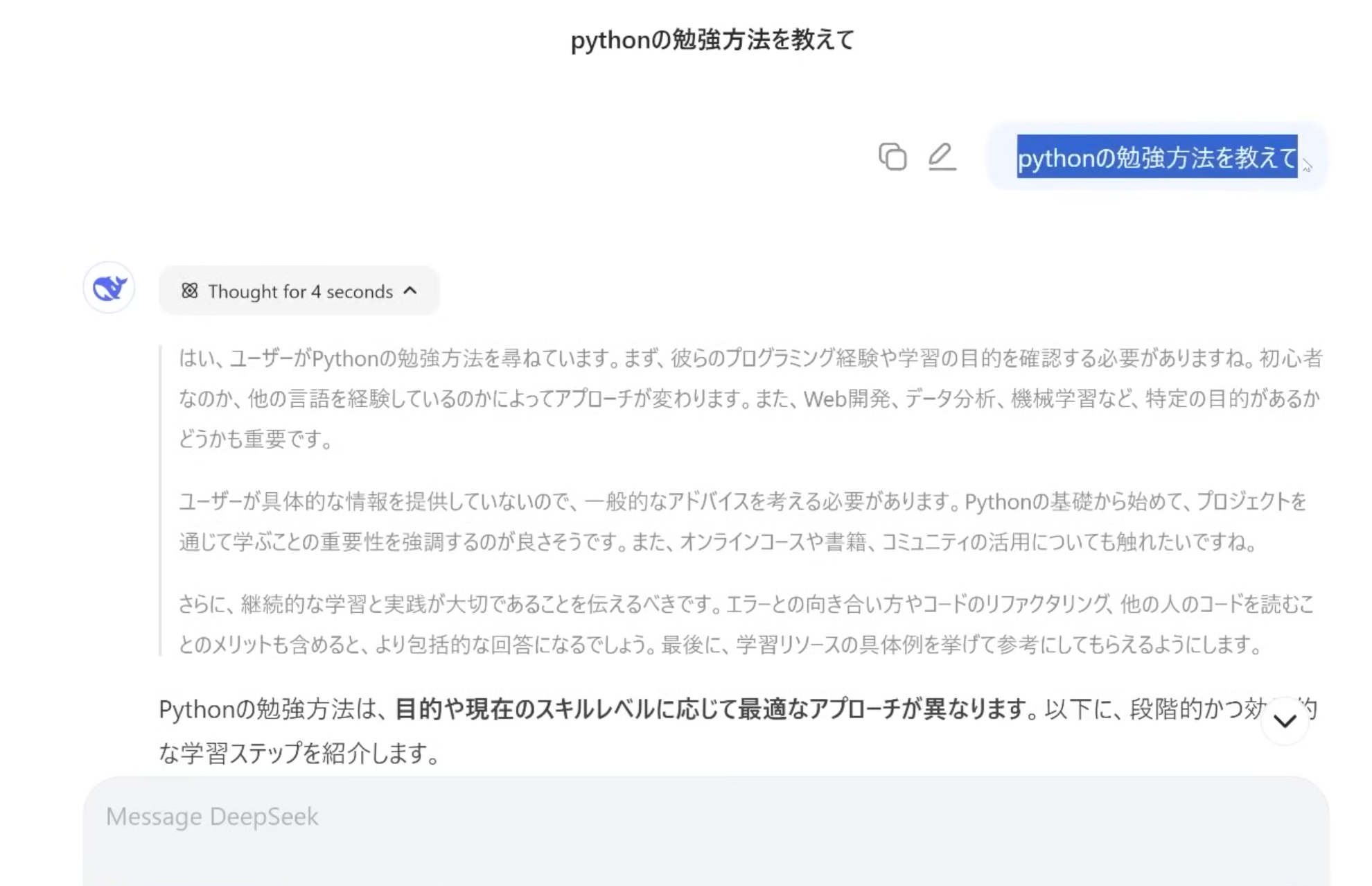

Web 検索機能と併用 することで、より正確な情報を取得可能。

推論過程が中国語で表示 されることがあるが、回答は指定言語(英語、日本語など)で提供される。

DeepSeek-R1とは?特徴・使い方・料金・導入メリットを詳しく解説!

業界トップの正確率で作業効率爆上げ!

近年、AI技術の発展により、大規模言語モデル(LLM)が注目を集めています。その中でも、DeepSeek-R1は、強化学習を活用し、高い推論能力とコストパフォーマンスを兼ね備えたオープンソースモデルとして注目されています。

本記事では、DeepSeek-R1の特徴や技術的な背景、料金体系、具体的な活用方法について詳しく解説します。特に、推論性能の向上、独自の開発手法、オープンソースの利点 に焦点を当て、その可能性を探ります。

LLM を活用したい企業や開発者にとって、DeepSeek-R1は有力な選択肢となるでしょう。

DeepSeek-R1とは?

DeepSeek-R1の概要

DeepSeek-R1は、2025年1月に発表された、中国のAI企業DeepSeekが開発した最新の大規模言語モデル(LLM)です。DeepSeekは、高性能なAIモデルの開発を手がける新興企業として知られ、特に推論能力に特化したモデルを提供しています。

DeepSeek-R1は、前モデルであるDeepSeek-V3を基盤に、強化学習(RL)を適用することで、論理的推論、コーディング、数学的問題解決能力を大幅に向上させました。この進化により、DeepSeek-R1は、従来のモデルに比べ、より精度の高い推論能力を発揮し、さまざまな業界での実用性が一層高まりました。

DeepSeek-R1-Zero と DeepSeek-R1 の違い

DeepSeek-R1の開発過程では、まずプロトタイプモデルである DeepSeek-R1-Zero が開発されました。その後、課題を克服し、より安定したDeepSeek-R1が誕生しました。

| 比較項目 | DeepSeek-R1-Zero | DeepSeek-R1 |

|---|---|---|

| 学習手法 | 強化学習(RL)のみ | 強化学習 + コールドスタートデータ |

| 推論能力 | 長期的な推論(Chain of Thought, CoT)に優れる | 精度向上・論理的な一貫性を強化 |

| 課題 | 無限ループの発生 | 無限ループ解消 |

| 可読性の低さ(長文出力の整合性問題) | 可読性が向上し、読みやすい文章を生成 | |

| 言語の混在(異なる言語が組み合わさる) | 言語処理の安定化 | |

| 強化ポイント | - | コールドスタートデータの導入により学習効率向上 |

| - | 強化学習の安定性向上・スムーズな出力 | |

| - | 推論精度の向上・より論理的な回答を生成 |

このアプローチにより、DeepSeek-R1は 高精度・高効率な LLM へと進化し、技術的にも大きなブレークスルーを達成しました。 DeepSeek-R1の開発過程では、まず DeepSeek-R1-Zero というプロトタイプモデルが開発されました。これは 教師あり微調整(SFT)を一切行わず、強化学習(RL)のみで学習 させた初期モデルです。DeepSeek-R1-Zero は、自己検証や長期的な推論(Chain of Thought, CoT)に優れた能力を示しましたが、以下のような課題も抱えていました。

無限ループの発生:同じ情報を繰り返すケースが見られた。

可読性の低さ:長文出力において、論理的に整合性の取れない部分があった。

言語の混在:異なる言語が意図せず組み合わさる問題が発生。

これらの課題を解決し、より安定したモデルとして開発されたのがDeepSeek-R1 です。

DeepSeek-R1では、強化学習を適用する前にコールドスタートデータ を少量組み込むことで、初期の学習効率を向上させました。このコールドスタートデータとは、モデルが正しい方向へ収束するために使用される少量の高品質な教師データのことを指します。これにより、

強化学習の安定性が向上:モデルがよりスムーズに適切な出力を生成。

可読性の改善:ユーザーが理解しやすい文章構造を生成。

推論精度の向上:より論理的で一貫性のある回答を出せるようになった。

このアプローチにより、DeepSeek-R1は 高精度・高効率な LLM へと進化し、技術的にも大きなブレークスルーを達成しました。

DeepSeek-R1の特徴

SFT による精度向上

Supervised Fine-Tuning(SFT)は、特定のドメインに適応するための教師あり学習の手法です。独自の専門データを活用することで、より精度の高い応答を提供できます。例えば、医学、法務、エンジニアリングなどの専門分野向けに調整することで、モデルの実用性が大幅に向上します。

RLHF(強化学習)の適用

RLHF(Reinforcement Learning from Human Feedback)を導入することで、モデルがユーザーのフィードバックを学習し、より自然で一貫性のある出力を生成できるようになります。特に、対話型 AI において、ユーザーの意図をより正確に理解し、適切な回答を返せるようになる点が強みです。

Distillation による小型モデルの最適化

Distillation(知識蒸留)技術を活用することで、DeepSeek-R1の優れた推論能力を小型モデルへ継承し、計算リソースの少ない環境でも利用しやすくなります。現在、Meta の Llama や Alibaba の Qwen など、多くのオープンソースモデルにも適用されており、小型で高性能なモデルが多数登場しています。

RAG(Retrieval-Augmented Generation)の統合

RAG を活用することで、モデルは外部知識をリアルタイムで取得し、より正確な回答を生成できます。特に、企業のナレッジベースやドキュメント検索と組み合わせることで、最新の情報を反映した高精度な出力が可能になります。

DeepSeek-R1では、RAG を組み込むことで、モデル単体では難しい最新ニュースや専門的な知識を補強し、ユーザーにとって価値のある回答を提供できます。

DeepSeek-R1の使い方

DeepSeek-R1は、さまざまな方法で利用可能です。用途に応じて最適な方法を選びましょう。

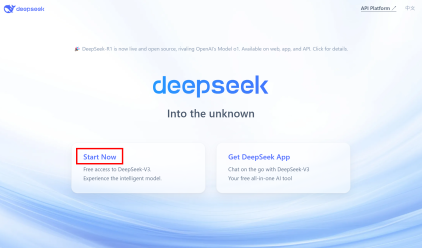

Web チャット(簡単に利用可能)

DeepSeek-R1は、公式サイトの Web チャットを通じて、ブラウザから簡単にアクセスできます。

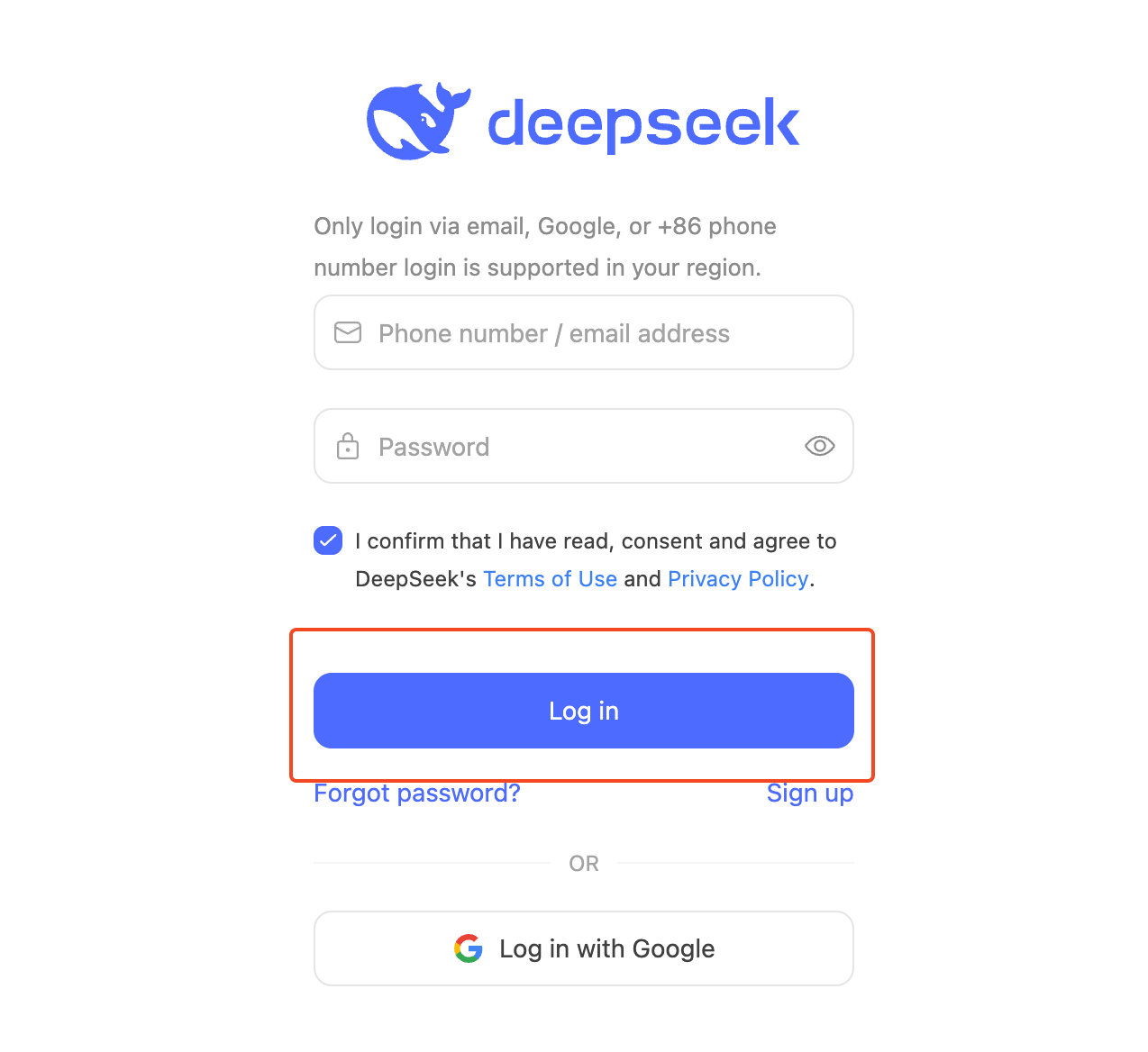

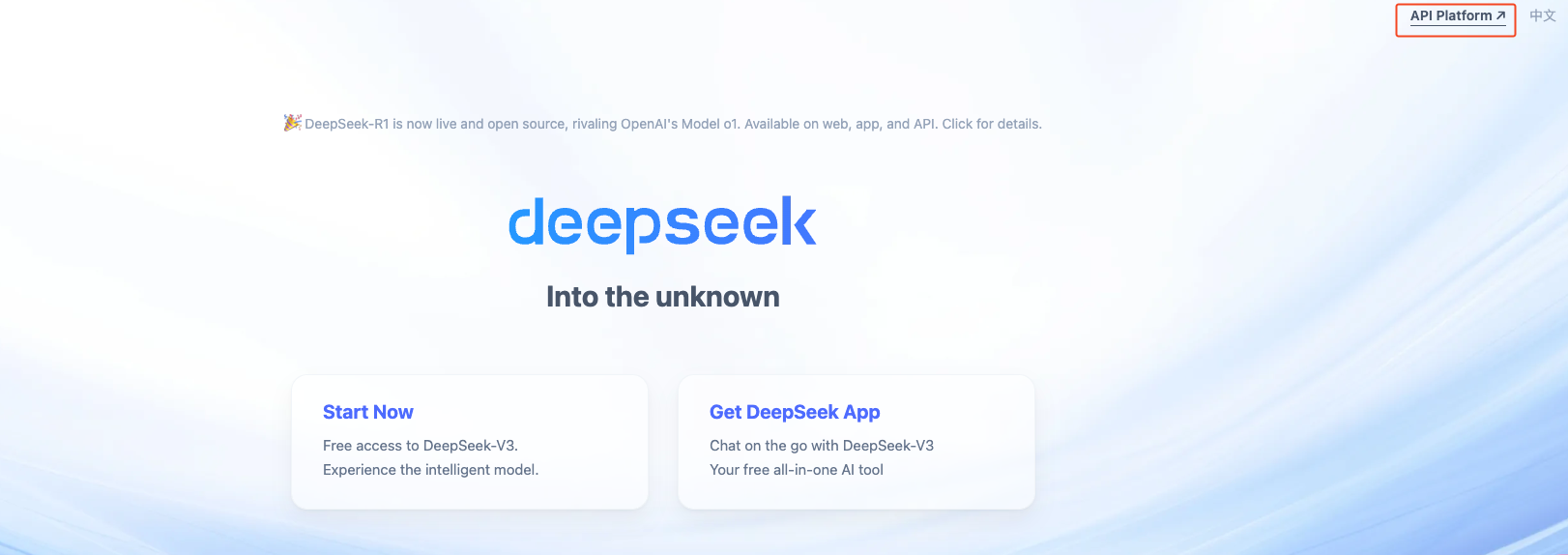

DeepSeek の公式サイト にアクセス。

アカウントを作成 または ログイン。

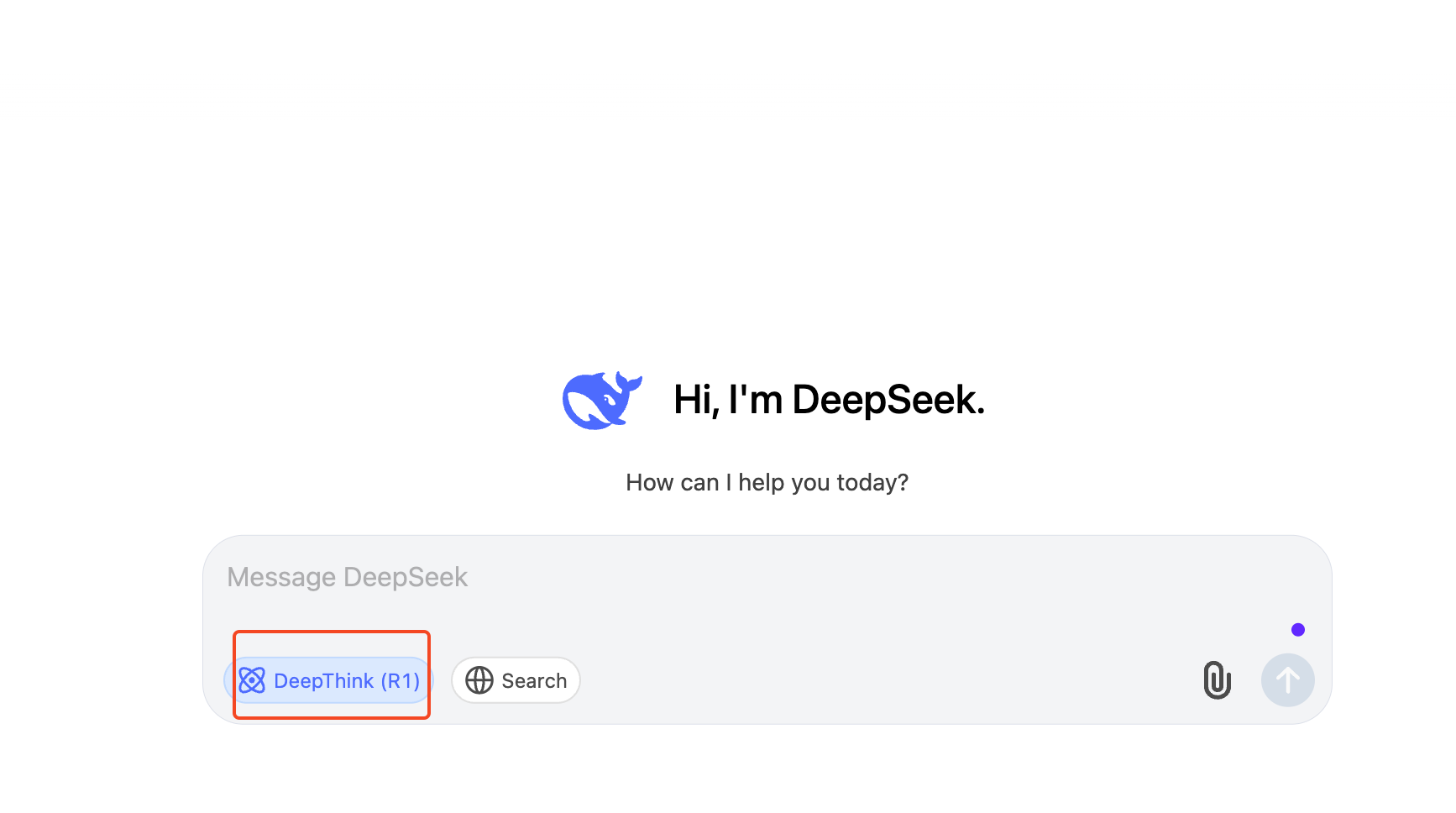

「DeepThink」ボタンをオン にして、DeepSeek-R1を有効化。

チャットボックスに質問を入力し、リアルタイムで応答を得る。

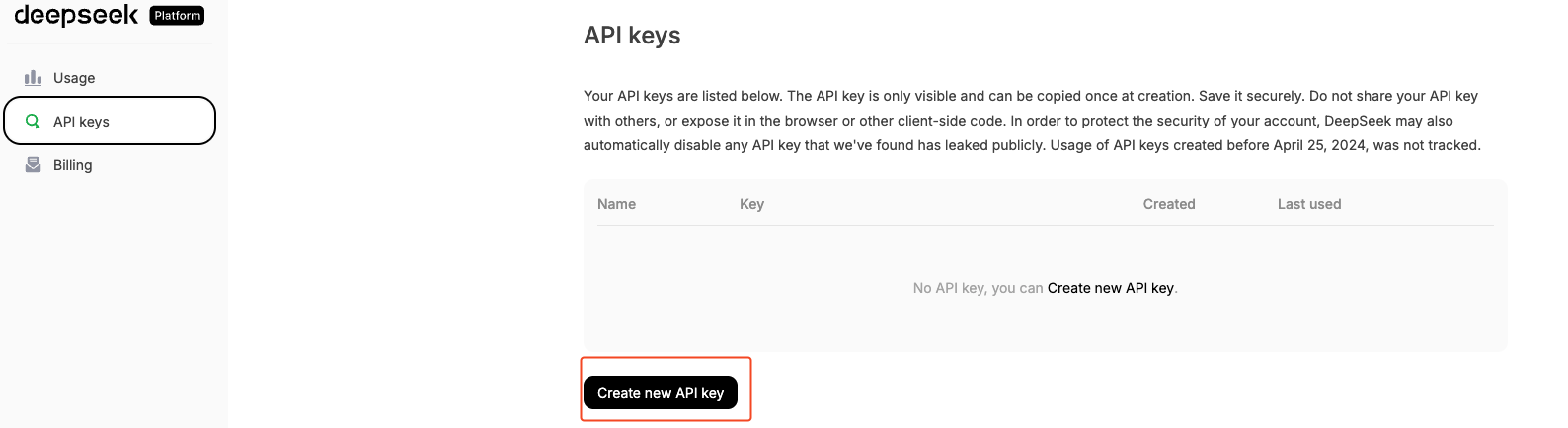

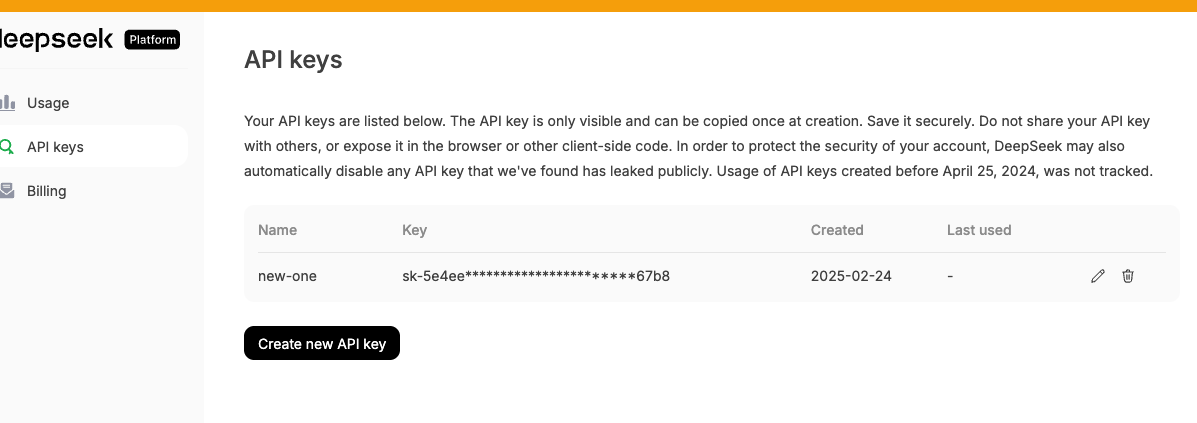

API 連携(開発者向け)

開発者は、DeepSeek-R1の API を活用して、アプリケーションやシステムに統合できます。

DeepSeek API プラットフォーム にアクセス。

アカウントを作成し、API キーを取得。

API ドキュメントを参照し、適切なエンドポイントを設定。

Python などの言語で API コールを実装。

import requests

headers = {"Authorization": "Bearer YOUR_API_KEY"}

data = {"prompt": "DeepSeek-R1の特徴を教えてください"}

response = requests.post("https://api.deepseek.com/v1/chat/completions", json=data, headers=headers)

print(response.json())OpenAI 互換 API なので、GPT ベースのアプリに簡単に統合可能。

レート制限があるため、用途に応じたプラン選択が重要。

3. ローカル環境での実行(技術者向け)

DeepSeek-R1は、ローカル環境での実行も可能です。

Python, CUDA 対応 GPU の環境を準備。

モデルをダウンロード(Hugging Face などから取得)。

実行スクリプトを設定。

pip install transformers torch

python run_model.py --model deepseek-r1高性能 GPU(16GB 以上) の利用が推奨。

Distill 版を使用 すると、リソース負荷を低減可能。

4. クラウド環境での利用(Azure, AWS, GCP)

DeepSeek-R1は、Azure AI Foundry だけでなく、AWS や GCP などのクラウド環境でもスケーラブルに運用可能です。

各クラウドの AI プラットフォームにアクセス。

DeepSeek-R1をデプロイし、インスタンスを作成。

API エンドポイントを取得し、クラウド環境で活用。

高性能 GPU(16GB 以上) の利用が推奨。

Distill 版を使用 すると、リソース負荷を低減可能。

DeepSeek-R1の料金

DeepSeek-R1は、オープンソースで利用可能ですが、API やクラウド環境での運用にはコストが発生する場合があります。以下に、料金体系とコストパフォーマンスについて詳しく説明します。

| プラン | 料金 | 特徴 |

|---|---|---|

| 無料プラン | ¥0 | 一定の制限内で無料利用可能(Web チャットや小規模 API コール) |

| 開発者プラン | 月額 ¥3,000 〜 | API のリクエスト上限が拡張され、ビジネス向け利用が可能 |

| エンタープライズプラン | 要相談 | 大規模なデータ処理、カスタムモデル対応、専用サーバー利用可能 |

無料プランでは 1 日あたりの API リクエスト数に制限があります。

有料プランでは、レート制限の緩和やカスタマイズオプションが提供されます。

OpenAI o1 シリーズとの料金比較

| モデル | 料金(1,000 トークンあたり) | 主要な特徴 |

|---|---|---|

| DeepSeek-R1 | ¥0.4 〜 ¥0.8 | 高性能・低コスト・オープンソース |

| OpenAI GPT-4 | ¥3.0 〜 ¥6.0 | 高精度・商業向け |

| Claude | ¥2.5 〜 ¥5.0 | 長文生成に優れる |

| Mistral | ¥0.6 〜 ¥1.2 | 小型軽量モデル・低コスト |

DeepSeek-R1はオープンソースモデルとして無料で利用可能ですが、API 経由の利用には料金が発生する。

GPT-4 や Claude と比較して、DeepSeek-R1は低コストでありながら高い性能を提供。

OpenAI GPT-4、Claude、Mistral との比較

DeepSeek-R1は、現在市場にある主要な LLM(大規模言語モデル)である OpenAI GPT-4、Claude、Mistral と比較して、コスト、性能、用途の柔軟性 という点で優れた特徴を持っています。以下の比較表を通じて、それぞれのモデルの違いを詳しく見ていきましょう。

モデル性能の比較

| モデル | パラメータ数 | 強み | 弱み |

|---|---|---|---|

| DeepSeek R1 | 約70B | 高精度推論、低コスト、オープンソース | 一部の言語タスクで最適化が必要 |

| GPT-4 | 約1T | 高精度な言語理解、企業向け最適化 | 高コスト、ブラックボックス設計 |

| Claude | 約100B | 長文処理、コンテキスト保持が強い | 応答速度が遅い、商業利用の制限 |

| Mistral | 約7B〜13B | 軽量で高速、小規模タスクに最適 | 推論精度が低め、大規模タスクに向かない |

DeepSeek-R1は、オープンソースでありながら高い推論精度を持つ点が強み。

GPT-4 は最も強力なモデルだが、コストと利用制限がネック。

Claude は長文の処理に特化しているが、API レイテンシが高め。

Mistral は軽量モデルとしての用途が強く、大規模な AI プロジェクトには不向き。

コストパフォーマンスの比較

| モデル | 料金(1,000 トークンあたり) | 商用利用 |

|---|---|---|

| DeepSeek R1 | ¥0.4 〜 ¥0.8 | 可能(MIT ライセンス) |

| GPT-4 | ¥3.0 〜 ¥6.0 | 可能(OpenAI 企業ライセンス) |

| Claude | ¥2.5 〜 ¥5.0 | 制限あり |

| Mistral | ¥0.6 〜 ¥1.2 | 可能(Apache 2.0) |

DeepSeek-R1は低コストでありながら高性能を提供。

GPT-4 は強力だが、API の利用料金が高め。

Claude は特定用途向けだが、商業利用に制約がある。

Mistral は小規模モデルとして使いやすいが、汎用性に限界がある。

どのモデルを選ぶべきか?

| ニーズ | 推奨モデル | 詳細 |

|---|---|---|

| 低コスト・オープンソース環境で高性能を求める場合 | DeepSeek-R1 | 高性能で低コスト、オープンソース環境に最適。 |

| 最高精度の AI を求め、コストを気にしない場合 | GPT-4 | 最高精度のAIを提供、コストを気にしない場合に最適。 |

| 長文処理が必要で、コンテキスト保持を重視する場合 | Claude | 長文の生成に優れ、コンテキストの保持が強力。 |

| 軽量で高速な推論が求められる場合 | Mistral | 軽量で高速な推論能力を持つ、リソース制限がある場合に最適。 |

DeepSeek 利用時の注意点

DeepSeek-R1を利用する際には、適切な活用を行うためにいくつかのポイントを理解しておく必要があります。以下の項目に注意して、より効果的にDeepSeek-R1を活用しましょう。

商業利用とライセンス(MIT ライセンス)

DeepSeek-R1は MIT ライセンスのもとで提供されており、商業利用が可能です。しかし、以下の点に注意が必要です。

商用サービスへの統合:

商用アプリケーションや SaaS プラットフォームに組み込む場合、ライセンス要件を確認。

オープンソースであるため、クレジット表記を求められる場合がある。

データの取り扱い:

プライバシーに配慮したデータ運用が必要。

法的な制約がある国や業界(金融、医療など)では、事前のコンプライアンス確認を推奨。

API 利用時のレート制限とコスト管理

DeepSeek-R1の API を利用する際には、以下の点を考慮することで効率的に活用できます。

レート制限(API の利用制限):

無料プランでは 1 日あたりのリクエスト数に上限がある。

商用利用を検討している場合、有料プランでレート制限を解除する必要がある。

コスト管理のポイント:

必要なリクエスト数を見積もり、適切なプランを選択。

キャッシュ機構を導入することで、同じクエリの再送信を減らしコストを最適化。

モデルの制約(推論速度・メモリ要件)

DeepSeek-R1は強力な LLM ですが、利用環境によっては制約が発生する場合があります。

推論速度の影響:

大規模なデータセットを処理する際、リクエストの待機時間が発生することがある。

高速な応答が必要なアプリケーションでは、事前に応答時間をテスト。

メモリ要件とローカル実行:

ローカル環境で実行する場合、高性能な GPU(16GB 以上推奨) を備えた環境が必要。

セキュリティとプライバシーの考慮

DeepSeek-R1を安全に利用するために、セキュリティ面での配慮が重要です。

データの送信と保存:

API 経由で送信するデータが第三者にアクセスされないように暗号化を使用。

保存されるデータがある場合、適切なアクセス管理を行う。

誤情報・バイアスへの対応:

LLM にはバイアスが含まれる可能性があるため、出力結果を慎重に確認。

自動生成されたコンテンツをそのまま公開せず、事前の検証を推奨。

DeepSeek-R1を適切に利用することで、安全かつ効果的に AI の力を活用することが可能です。これらの注意点を踏まえて、最適な活用方法を検討しましょう。

今後の展望と課題

オープンソースの持続可能性

DeepSeek-R1の持続可能性を確保するためには、開発者コミュニティの貢献や、商業利用とのバランスが鍵です。GitHub や Hugging Face などでのフィードバックを強化し、企業向けサービスの提供を通じて、オープンソース開発を維持していくことが求められます。

データ品質とモデルの透明性

高品質なトレーニングデータを確保するため、データの公開や監査プロセスを強化し、バイアスを最小限に抑える取り組みが重要です。また、多言語・多文化に対応したデータを収集し、最新の知識をモデルに組み込むことも求められます。

高性能モデルの計算コストと最適化

DeepSeek-R1のような大規模モデルは、計算コストが課題です。推論コストを削減するため、量子化や蒸留技術を活用し、ローカル環境でも動作する軽量版の開発が進められています。さらに、省エネモデルやグリーンコDeepSeek-R1ンピューティングの活用も検討されています。

商業利用とエコシステムの拡大

DeepSeek-R1の普及を加速させるためには、企業向けソリューションや、開発者向けのツールやチュートリアルの充実が不可欠です。教育機関や研究機関との連携を強化し、AI の民主化を進めることも重要です。

まとめ

DeepSeek-R1 は、技術力・柔軟性・低コストを兼ね備えたオープンソース LLM です。低コスト:無料試用可能で、クラウドや API 連携もリーズナブル。カスタマイズ性:自社サーバー・ローカル環境で運用可能。開発環境の自由度:MIT ライセンスのもと、研究や応用が容易。DeepSeek-R1は、企業・研究機関・開発者にとって魅力的な選択肢となり、AI 開発の未来を切り拓く存在となるでしょう。

Nottaが選ばれる理由は?

①簡単かつ迅速。最大5時間の音声を数分で文字に変換できます。

②高音質な音声の書き起こし精度は98.86%に達しています。

③国内唯一のZoom/Google Meet/Teams連携で、 社内会議、オンライン授業を文字起こしできます。